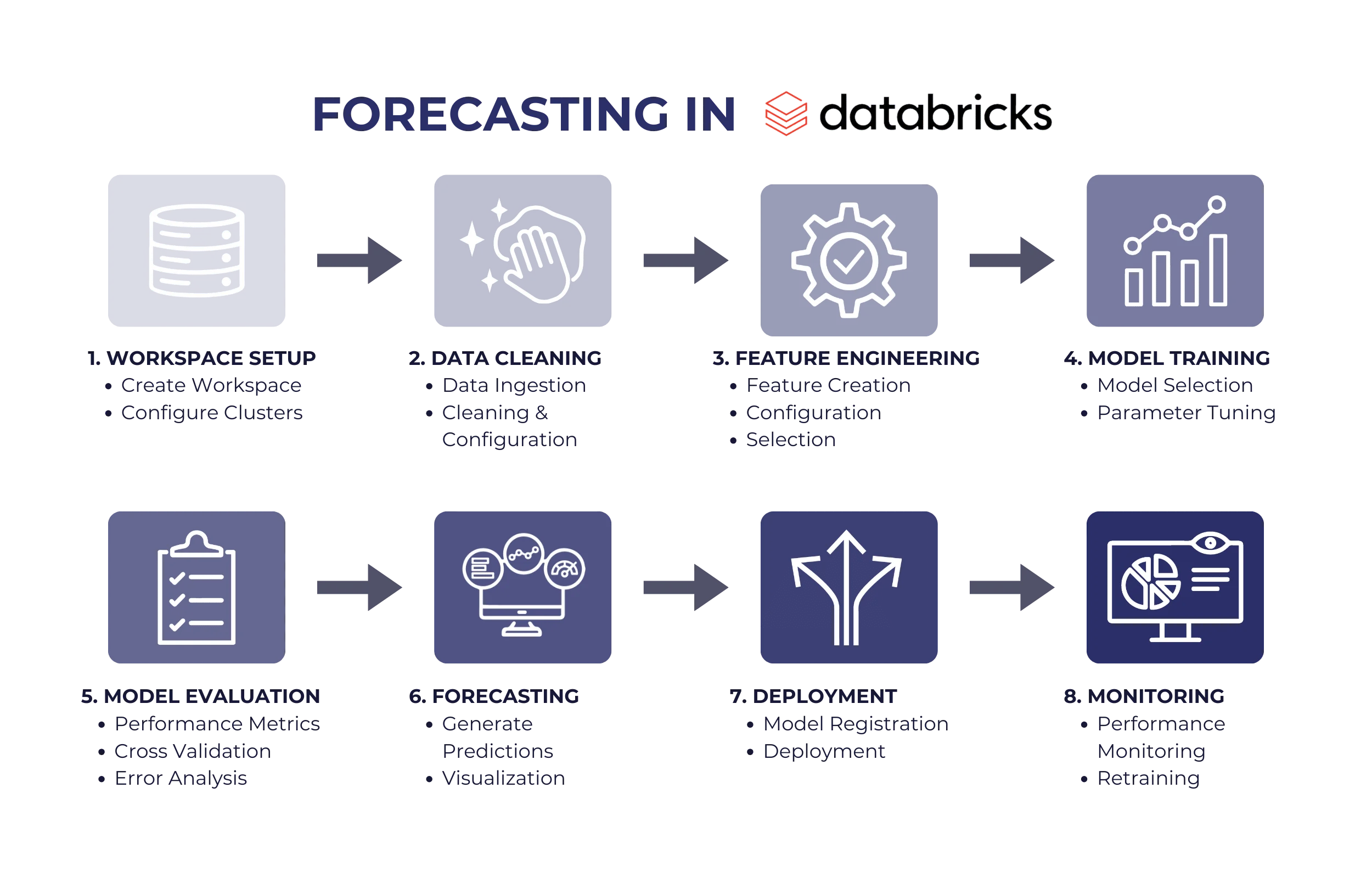

Nutzen Sie Machine Learning Features in Databricks für Ihre Prognosen

Prognosen sind eine wichtige Voraussetzung für eine datengestützte Entscheidungsfindung, die es Unternehmen ermöglicht, zukünftige Trends und Ergebnisse auf der Grundlage historischer Daten vorherzusagen. Databricks bietet eine robuste Plattform für die effiziente Erstellung und Bereitstellung von Prognosemodellen.

Table of Contents

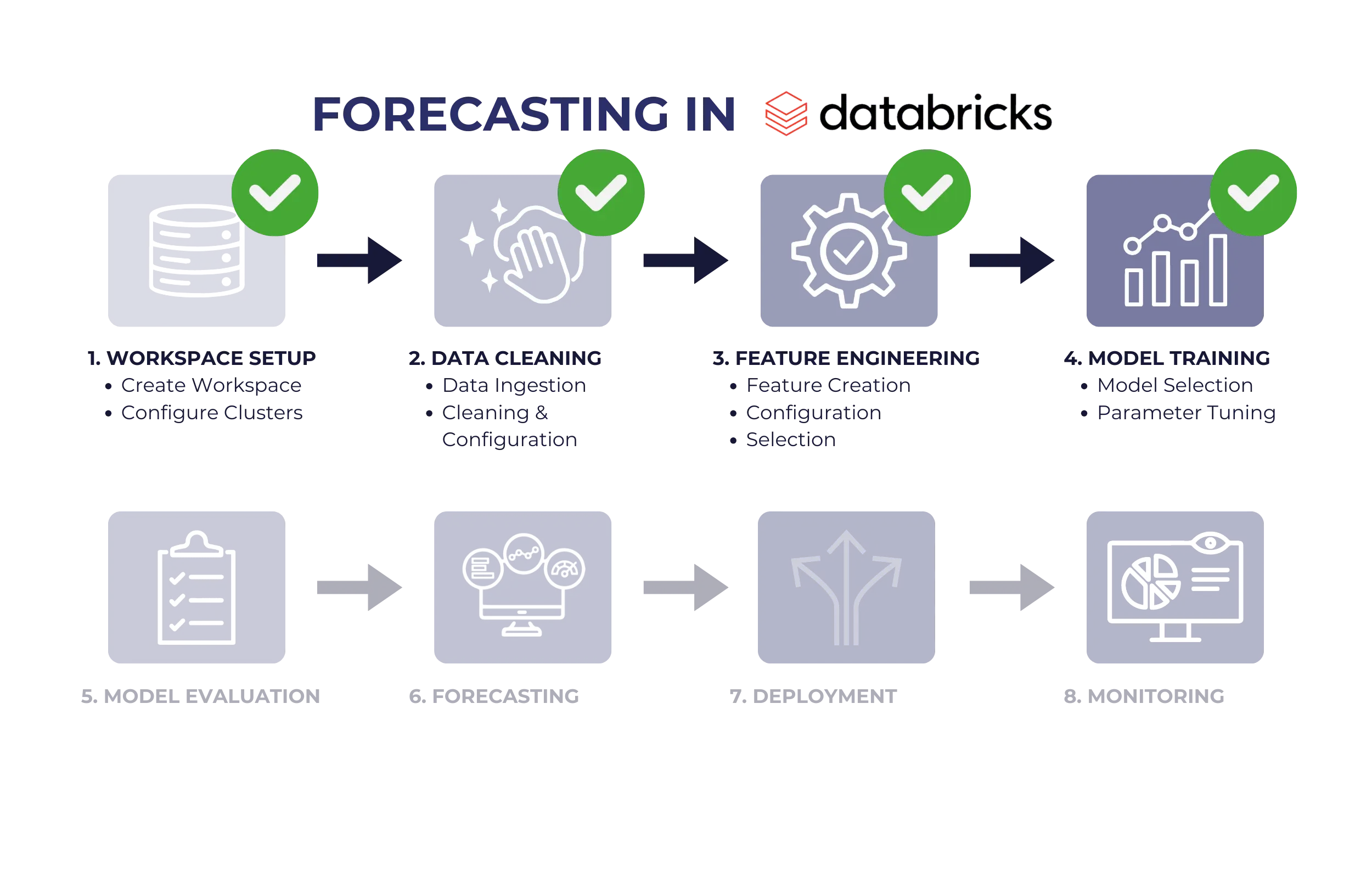

In diesem Leitfaden führen wir Sie durch alles, was Sie wissen müssen, um Ihre Databricks-Umgebung für eine optimale Prognoseleistung einzurichten. Von der Vorbereitung Ihres Arbeitsbereichs bis hin zur Feinabstimmung und Überwachung der bereitgestellten Modelle erhalten Sie praktische Einblicke und Best Practices, um sicherzustellen, dass Ihre Prognoseprojekte reibungslos ablaufen und umsetzbare Ergebnisse liefern. Ganz gleich, ob Sie gerade erst anfangen oder Ihr bestehendes Setup verbessern möchten, dieser Leitfaden vermittelt Ihnen das nötige Wissen, um Databricks für Prognosen optimal zu nutzen.

1. Einrichten Ihrer Databricks-Umgebung

Erstellen eines Arbeitsbereichs

Der erste Schritt zur Nutzung von Databricks ist die Einrichtung Ihres Arbeitsbereichs:

-

Anmeldung und Einrichtung: Melden Sie sich bei der Databricks-Plattform an und erstellen Sie Ihren Arbeitsbereich. Dieser Arbeitsbereich dient als zentrale Anlaufstelle für die Verwaltung von Clustern, Notizbüchern, Bibliotheken und anderen Ressourcen.

-

Benutzerberechtigungen: Definieren Sie Zugriffsberechtigungen, um eine ordnungsgemäße Zusammenarbeit innerhalb Ihres Teams sicherzustellen. Weisen Sie Benutzern je nach ihren Aufgaben Rollen wie Administrator, Mitwirkender oder Betrachter zu. Dies fördert die Sicherheit und Verantwortlichkeit und stellt sicher, dass Teammitglieder nur auf die Ressourcen zugreifen können, die sie benötigen.

Clusterkonfiguration

Ein Cluster ist die Recheneinheit, die Ihre Daten verarbeitet:

-

Clustertyp: Wählen Sie den Typ entsprechend Ihren Anforderungen aus. Cluster mit einem Knoten sind kostengünstig für Tests, während Cluster mit mehreren Knoten ideal für umfangreiche Produktions-Workloads sind.

-

Ressourcenzuweisung: Konfigurieren Sie Ressourcen wie CPU und Speicher basierend auf der Größe Ihres Datensatzes und der Komplexität Ihrer Prognosemodelle. Rechenintensivere Modelle, wie z. B. Deep-Learning-Algorithmen, erfordern größere Cluster.

-

Notebook-Anbindung: Binden Sie Notebooks an Cluster an, um interaktiv Skripte zu entwickeln, zu testen und auszuführen, wodurch sich Ihre Arbeitsabläufe einfacher iterieren und verfeinern lassen.

In dieser Phase haben Sie Ihren Arbeitsbereich eingerichtet und Cluster für die Verarbeitung eingerichtet. Mit einer sicheren Umgebung, die für die Zusammenarbeit bereit ist, sind Sie für die Arbeit mit Ihren Daten gerüstet. Im nächsten Schritt geht es darum, Ihre Daten für die Prognose vorzubereiten und zu organisieren.

2. Datenvorbereitung

Datenerfassung

Das Sammeln und Organisieren von Daten ist die Grundlage für Prognosen:

-

Datenquellen: Importieren Sie Daten aus verschiedenen Formaten und Speicherorten, z. B. CSVs, Parquet-Dateien, SQL-Datenbanken oder Cloud-Speicher (z. B. AWS S3, Azure Data Lake). Databricks unterstützt Konnektoren für eine nahtlose Integration.

-

Integrierte Tools: Nutzen Sie die integrierten Optionen von Databricks, um Dateien hochzuladen oder direkte Verbindungen zu Ihren Datenquellen zu konfigurieren.

Datenanalyse

Ein Verständnis Ihrer Daten hilft bei der Steuerung der Vorverarbeitungsschritte:

-

Vorschau der Struktur: Verwenden Sie SQL-Abfragen oder Python/PySpark in Notizbüchern, um Datensätze zu untersuchen und Spaltentypen, Verteilungen und Anomalien zu identifizieren.

-

Zusammenfassende Statistiken: Generieren Sie Metriken wie Mittelwert, Median, Standardabweichung und Häufigkeitszahlen, um ein umfassendes Verständnis der Daten zu erlangen.

Datenbereinigung

Bereinigte Daten gewährleisten die Genauigkeit des Modells:

-

Umgang mit fehlenden Werten: Beheben Sie Lücken, indem Sie fehlende Daten mithilfe von Mittel-, Median- oder Modalwerten imputieren oder unvollständige Datensätze entfernen.

-

Standardisierung: Normalisieren Sie Merkmale auf eine einheitliche Skala (z. B. mithilfe von Min-Max-Skalierung oder Z-Scores), um zu verhindern, dass größere Werte das Modell überproportional beeinflussen.

-

Konsistente Formatierung: Stellen Sie sicher, dass Felder wie Datums- und Zeitangaben korrekt analysiert und in geeigneten Formaten (z. B. Datums-/Zeitobjekte) gespeichert werden.

Am Ende dieser Phase sind Ihre Daten organisiert, untersucht und bereinigt, sodass die Voraussetzungen für eine effektive Prognose gegeben sind. Als Nächstes konzentrieren Sie sich auf die Entwicklung von Funktionen, um aussagekräftige Erkenntnisse aus Ihren Daten zu gewinnen.

3. Merkmals-Engineering

Merkmal-Erstellung

Neue Merkmale können die Modellleistung verbessern, indem sie zugrunde liegende Muster aufdecken:

-

Zeitbasierte Merkmale: Enthalten Indikatoren wie Wochentag, Monat, Saisonalität oder Feiertagskennzeichen, um zeitliche Schwankungen zu erfassen.

-

Domänenspezifische Merkmale: Berechnen Sie relevante Aggregate wie gleitende Durchschnitte oder Verhältnisse, um einen für das Prognoseproblem spezifischen Kontext bereitzustellen.

Merkmalstransformation

Die Verfeinerung von Merkmalen verbessert die Interpretierbarkeit und Genauigkeit des Modells:

-

Skalierung und Kodierung: Normalisieren Sie numerische Merkmale, um die Kompatibilität mit Algorithmen für maschinelles Lernen zu verbessern. Kodieren Sie kategoriale Merkmale mithilfe von Techniken wie One-Hot-Encoding oder Label-Encoding.

-

Ausreißer-Handling: Mildern Sie die Auswirkungen von Ausreißern durch Transformationen (z. B. Log-Skalierung) oder das Begrenzen von Extremwerten.

Merkmalsauswahl

Wählen Sie die aussagekräftigsten Merkmale aus:

-

Automatisierte Tools: Nutzen Sie Korrelationsmatrizen, Varianzschwellenwerte oder fortgeschrittene Methoden wie SHAP-Werte (SHapley Additive exPlanations), um aussagekräftige Merkmale zu priorisieren.

-

Dimensionalitätsreduktion: Verwenden Sie Techniken wie die Hauptkomponentenanalyse (PCA), um redundante oder verrauschte Merkmale zu eliminieren.

Mit diesem Schritt haben Sie einen robusten Satz von Merkmalen erstellt und optimiert, die Muster in Ihren Daten aufdecken. Jetzt sind Sie bereit, Ihre Modelle zu trainieren, um genaue Vorhersagen zu treffen.

4. Modell-Training

Modellauswahl

Wählen Sie einen Algorithmus, der zu Ihren Daten passt:

-

Traditionelle Modelle: ARIMA (AutoRegressive Integrated Moving Average) oder SARIMA (Seasonal ARIMA) sind für Zeitreihendaten mit erkennbaren Trends und Saisonalität geeignet.

-

Modelle für maschinelles Lernen: Techniken wie XGBoost, Random Forest oder neuronale Netze eignen sich für komplexe Datensätze, bei denen traditionelle Modelle möglicherweise nicht ausreichen.

Trainingssprozess

Teilen Sie die Daten in Teilmengen auf, um eine Überanpassung zu vermeiden:

-

Datensplits: Daten in Trainings-, Validierungs- und Testsätze aufteilen. Trainingssätze dienen zur Modellierung, Validierungssätze zur Feinabstimmung von Parametern und Testsätze zur Leistungsbewertung.

-

Historische Muster: Konzentrieren Sie sich auf die Identifizierung wiederkehrender Trends, saisonaler Effekte oder Anomalien in historischen Daten.

Hyperparameter-Tuning

Modelle für Spitzenleistung optimieren:

-

Grid Search: Kombinieren Sie Parameter systematisch, um die beste Konfiguration zu ermitteln.

-

Bayessche Optimierung: Probabilistische Modelle verwenden, um Parameterräume effizient zu erkunden und optimale Einstellungen zu finden.

Wenn Ihr Modell trainiert und optimiert ist, steht Ihnen ein Tool zur Verfügung, mit dem Sie Vorhersagen erstellen können. Im nächsten Schritt wird die Genauigkeit des Modells bewertet und seine Zuverlässigkeit sichergestellt.

5. Modellbewertung

Leistungskennzahlen

Quantifizierung der Modellgenauigkeit und -zuverlässigkeit:

-

Kennzahlen: Bewertung der Leistung anhand von Kennzahlen wie dem mittleren absoluten Fehler (MAE) für die durchschnittliche Genauigkeit, dem mittleren quadratischen Fehler (RMSE) zur Bestrafung größerer Abweichungen und dem mittleren absoluten prozentualen Fehler (MAPE) für die relative Genauigkeit.

Kreuzvalidierung

Sicherstellung der Modellrobustheit:

-

K-Fold-Validierung: Teilen Sie die Daten in k Teilmengen auf und verwenden Sie jede Teilmenge nacheinander als Testsatz, um die Stabilität und Generalisierung zu bewerten.

Fehleranalyse

Identifizieren Sie Schwachstellen in Modellvorhersagen:

-

Residual Plots: Untersuchen Sie die Unterschiede zwischen beobachteten und vorhergesagten Werten, um systematische Fehler zu erkennen.

Zu diesem Zeitpunkt wurde Ihr Modell einer strengen Bewertung auf Genauigkeit und Zuverlässigkeit unterzogen. Als Nächstes verwenden Sie das trainierte Modell, um Prognosen zu erstellen und Ergebnisse zu visualisieren.

6. Forecasting

Prognosen erstellen

Verwenden Sie trainierte Modelle, um zukünftige Werte vorherzusagen:

-

Zukünftige Daten: Geben Sie unsichtbare Datensätze ein, um Prognosen für bestimmte Zeiträume zu erstellen.

Szenario-Tests

Testen Sie hypothetische Situationen, um das Modellverhalten zu beurteilen:

-

Was-wäre-wenn-Analyse: Simulieren Sie verschiedene Eingaben, um zu verstehen, wie sich Änderungen auf die Ergebnisse auswirken.

Visualisierung

Ergebnisse effektiv präsentieren:

-

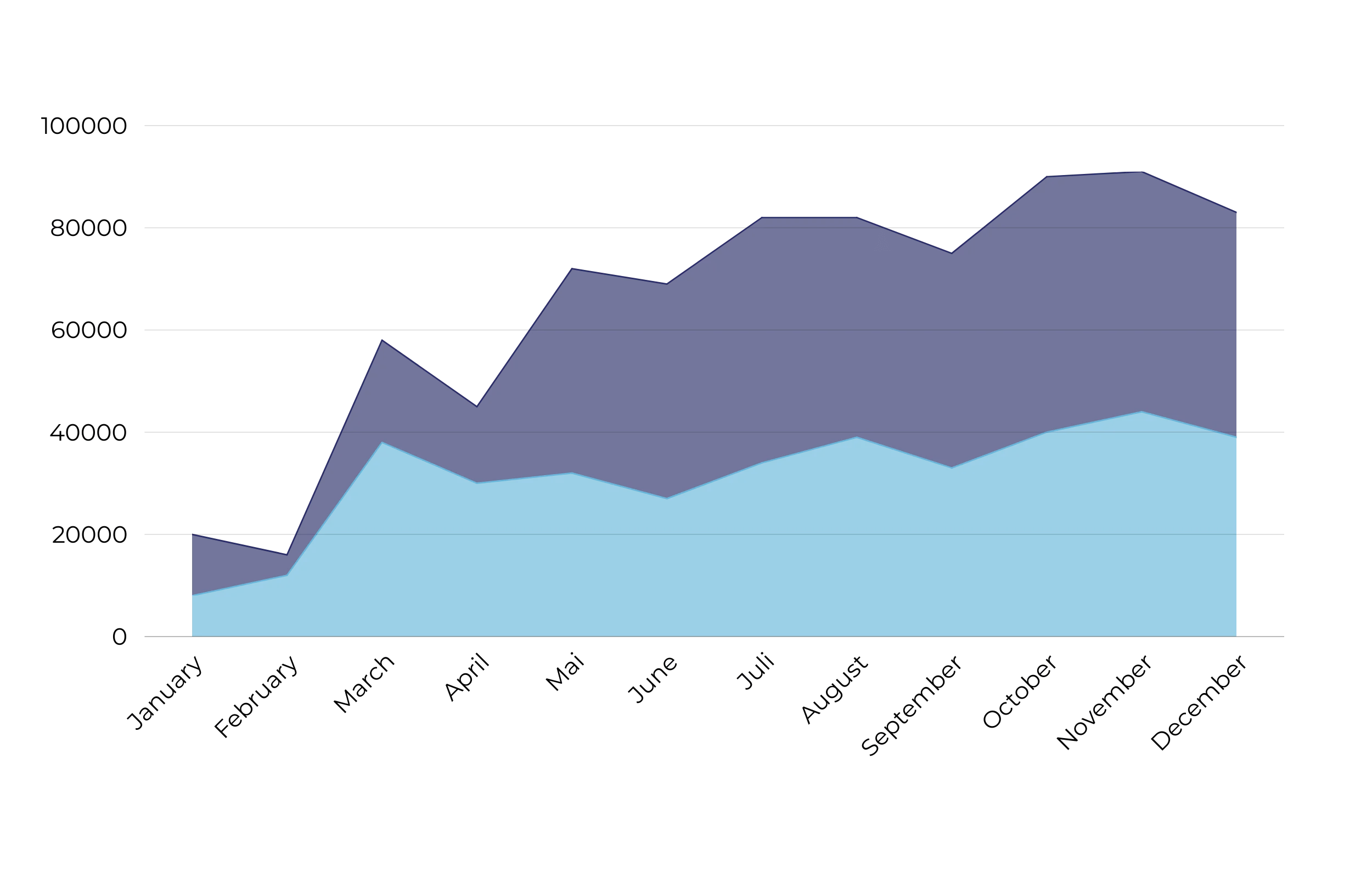

Grafische Ausgaben: Verwenden Sie Liniendiagramme, Streudiagramme oder Heatmaps, um Prognosen, Konfidenzintervalle und Trends zu visualisieren.

Sie verfügen nun über umsetzbare Prognosen und klare Visualisierungen, um Ergebnisse zu kommunizieren. Der nächste Schritt besteht darin, das Modell für die fortlaufende Nutzung und Integration in Geschäftsprozesse bereitzustellen.

7. Modellbereitstellung

Modellregistrierung

Organisieren und versionieren Sie Modelle für eine einfache Verwaltung:

-

Registrierung: Speichern Sie trainierte Modelle zusammen mit Metadaten (z. B. Trainingsdaten, Versionshistorie und Parameter) in der Databricks-Modellregistrierung.

Bereitstellungsoptionen

Stellen Sie Prognosen in Formaten bereit, die für Ihren Anwendungsfall geeignet sind:

-

Stapelverarbeitung: Planen Sie Aufträge für regelmäßige Aktualisierungen.

-

Echtzeitbereitstellung: Richten Sie APIs für sofortige Vorhersagen ein.

Integration

Integrieren Sie Vorhersagen in Business-Tools:

-

Dashboards: Verbinden Sie Ausgaben mit Visualisierungstools wie Tableau oder Power BI, um die Entscheidungsfindung zu verbessern.

Wenn Ihr Modell bereitgestellt und Vorhersagen in Arbeitsabläufe integriert sind, verlagert sich der Fokus auf die Überwachung und Aufrechterhaltung der Leistung im Laufe der Zeit.

8. Überwachung und Wartung

Leistungsüberwachung

Verfolgung und Aufrechterhaltung der Modellwirksamkeit:

-

Schlüsselkennzahlen: Regelmäßige Überwachung der Genauigkeit, Datendrift (Änderungen der Eingabedaten) und Laufzeitleistung.

Feedbackschleifen

Verfeinern Sie Modelle mit Erkenntnissen aus der Praxis:

-

Benutzerfeedback: Berücksichtigen Sie die Rückmeldungen von Endbenutzern, um Modelle an die tatsächlichen Bedürfnisse anzupassen.

Umschulung

Halten Sie Modelle relevant:

-

Regelmäßige Aktualisierungen: Schulen Sie Modelle anhand neuer Daten um, um sie an sich entwickelnde Trends und Bedingungen anzupassen.

In dieser Phase wird Ihr eingesetztes Modell kontinuierlich überwacht und verfeinert, um sicherzustellen, dass es auch bei sich ändernden Bedingungen genau und relevant bleibt.

Fazit – ein nahtloser Workflow für Ihre Datenaufgaben

Databricks ist eine leistungsstarke Plattform, die die Komplexität moderner Datenverarbeitung, -analyse und -prognose vereinfacht. Von der Einrichtung Ihres Arbeitsbereichs und der Datenvorbereitung bis hin zur Entwicklung von Funktionen, Trainingsmodellen und der Bereitstellung von Prognosen bietet sie einen nahtlosen, integrierten Workflow für die Bewältigung selbst anspruchsvollster Datenaufgaben. Die Möglichkeit, die Rechenleistung zu skalieren, eine Vielzahl von maschinellen Lerntechniken zu nutzen und Modelle zu überwachen, stellt sicher, dass Sie in einer zunehmend datengesteuerten Welt immer einen Schritt voraus sind.

Bei der Durchführung des Prozesses ist es von entscheidender Bedeutung, saubere und gut organisierte Daten zu pflegen, die richtigen Funktionen auszuwählen und Algorithmen zu wählen, die auf Ihren spezifischen Anwendungsfall zugeschnitten sind. Ebenso wichtig ist die Notwendigkeit einer ständigen Überwachung und Nachschulung, um die Genauigkeit und Relevanz Ihrer Modelle zu gewährleisten. Wenn Unternehmen diese Aspekte beherrschen, können sie umsetzbare Erkenntnisse gewinnen, Abläufe optimieren und fundierte Entscheidungen treffen.

Bei KEMB sind wir auf datengesteuerte Wachstumsstrategien spezialisiert und nutzen Plattformen wie Databricks, um Unternehmen bei der Erreichung ihrer Ziele zu unterstützen. Ganz gleich, ob Sie gerade erst mit Databricks beginnen oder Ihre bestehende Einrichtung optimieren möchten, unser Expertenteam steht Ihnen bei jedem Schritt zur Seite. Kontaktieren Sie uns noch heute, um zu erfahren, wie wir Ihnen helfen können, das volle Potenzial von Databricks auszuschöpfen und Ihre Datenstrategie auf die nächste Stufe zu heben. Lassen Sie uns gemeinsam intelligentere Entscheidungen treffen!